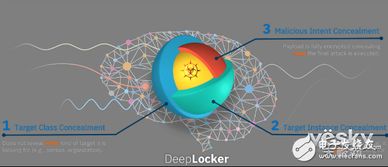

人工智能恶意软件 利用AI模型隐藏恶意的新型威胁

随着人工智能技术的飞速发展,其在医疗、教育、交通等领域的应用日益广泛。技术的发展往往伴随着新的挑战,人工智能恶意软件的出现,便是这一背景下不容忽视的网络安全新威胁。这类恶意软件能够利用人工智能模型自身的复杂性和隐蔽性,来隐藏其恶意意图与行为,对人工智能应用软件开发与部署构成了前所未有的风险。

传统恶意软件通常依赖于已知的漏洞或简单的代码混淆技术来逃避检测。而人工智能恶意软件则更为高级,它能够将恶意代码或行为“嵌入”到AI模型的参数、结构或训练数据中。例如,攻击者可以训练一个看似正常的图像分类模型,但其内部却包含了用于数据窃取、系统破坏或后门开启的恶意逻辑。由于AI模型本身是一个复杂的“黑箱”,其内部运作机制往往难以完全解释,这使得检测嵌入其中的恶意代码变得异常困难。

这种隐蔽性带来了多重风险。它威胁着人工智能应用软件的安全开发生命周期。开发者在集成第三方AI模型或使用预训练模型时,可能无意中引入了恶意组件。它挑战了现有的安全检测体系。传统的基于特征码或行为分析的防病毒软件,可能无法有效识别这种深度整合在模型内部的威胁。它可能被用于发起高度针对性的高级持续性威胁(APT)攻击,危害关键基础设施、企业机密乃至国家安全。

面对这一新兴威胁,人工智能应用软件的开发者和安全社区需要采取多层次的防御策略。

- 供应链安全与模型审计:建立严格的AI模型供应链安全管理规范。对引入的第三方模型、训练数据集和开源库进行严格的安全审计与验证,确保其来源可信。推动模型“可解释性”研究,开发能够剖析模型内部决策逻辑的工具,以发现潜在的恶意植入。

- 开发安全实践(DevSecOps for AI):将安全考量深度融入AI应用的开发、部署与运维全过程(即AI领域的DevSecOps)。这包括在模型训练阶段监控异常模式,在部署前进行对抗性样本测试和恶意行为模拟,以及在运行期间持续监控模型的输入、输出和资源使用情况。

- 新型检测技术研发:投资研发专门针对AI模型的安全检测技术。例如,开发能够分析模型参数分布异常、检测隐蔽后门触发机制、或识别模型在特定输入下产生恶意输出的新型安全工具。

- 行业标准与法规:政府和行业组织应加快制定关于AI模型安全性的标准、测试基准和法规框架。明确AI模型开发、提供和使用各方的安全责任,促进安全信息的共享,共同构建抵御AI恶意软件的生态系统。

- 安全意识与培训:提升AI开发者、研究人员和最终用户的安全意识。使其了解AI恶意软件的潜在风险,并在日常工作中采取基本的安全预防措施,如不随意运行来源不明的模型,定期更新和修补系统等。

人工智能是一把双刃剑,它在赋能千行百业的其技术特性也可能被恶意利用。人工智能恶意软件的出现,标志着网络攻击进入了利用AI技术进行隐蔽和逃逸的新阶段。这要求我们在拥抱AI创新的必须以前瞻性的眼光,构建与之匹配的、主动的、纵深的安全防御体系。只有通过开发者、安全研究者、企业和监管机构的协同努力,才能确保人工智能技术在安全、可信的轨道上持续发展,真正造福社会。

如若转载,请注明出处:http://www.china-welfare.com/product/18.html

更新时间:2026-02-24 02:09:08